Was wir aus Benchmark-Apps lernen wollen

AnTuTu, Geekbench und Vellamo liefern vergleichbare Messwerte. Doch was sagen Benchmarks uns wirklich? Wir wollen den Performance-Abschnitt unserer Tests überarbeiten. Jetzt laden wir Euch ein, mitzumachen: Helft uns bei der Suche nach den besten Benchmark-Apps und -Praktiken.

Die Rechenleistung moderner Smartphones reicht inzwischen für erstaunliche Aufgaben aus: 3D-Spiele im VR-Headmount, Bildbearbeitung in Echtzeit, Video-Aufnahmen in 4K-Auflösung, parallele Analyse etlicher Sensoren, Multitasking zwischen komplexen Anwendungen ohne Ladezeiten, Herunterladen großer Datenmengen aus dem mobilen Datennetz mit 300 Mbit/s.

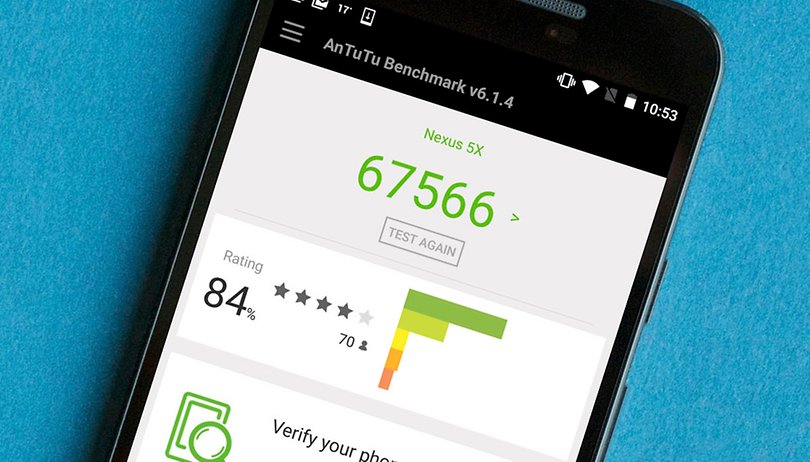

Um jedoch zuverlässig zu sagen, ob ein Smartphone schneller als ein anderes ist, braucht es normierte Tests. Diese werden in Form von Benchmarks von unterschiedlichen Entwicklerschmieden herausgegeben. Eine der bekannteren ist AnTuTu. Ihr Geld verdienen die chinesischen Entwickler mit Stresstests, die sie an Smartphone-Hersteller verkaufen.

Der normale Anwender kennt sie vom AnTuTu-Benchmark. Die Play-Store-App ist die wahrscheinlich bekannteste Messlatte für den Leistungsvergleich von Android- und iOS-Geräten. Leider mussten wir beschließen, sie aus dem Benchmark-Parcours zu entfernen. Während die Messdaten dank der Online-Datenbank eine gute Vergleichbarkeit versprachen, liefen die häufigen App-Updates genau diesem Vorteil zuwider. Immer wieder verschob sich die Skala, sodass die Messwerte eines Testgerätes vom einen Tag auf den anderen um 50 Prozent abwichen, weil AnTuTu aktualisiert wurde.

Dies brachte uns in Zugzwang und wir begaben uns auf die Suche nach alternativen Messmethoden für die Performance der Testgeräte. Grundlegende Fragen taten sich auf: Was wollen wir wissen? Was macht eine gute Benchmark-App aus? Dabei ermittelten wir folgende Hauptkriterien:

- Die Messwerte müssen langfristig vergleichbar bleiben

- Die App muss den Lesern kostenlos zur Verfügung stehen

Darüber hinaus zeichnen sich wichtige Unterkriterien ab, die sich auf Benchmark-Details beziehen. Diese möchte ich am Beispiel PCMark for Android erläutern. Denn jede Benchmark-App geht auf spezifische Kennzahlen ein und blendet dabei wichtige andere Werte aus.

PCMark for Android Benchmark

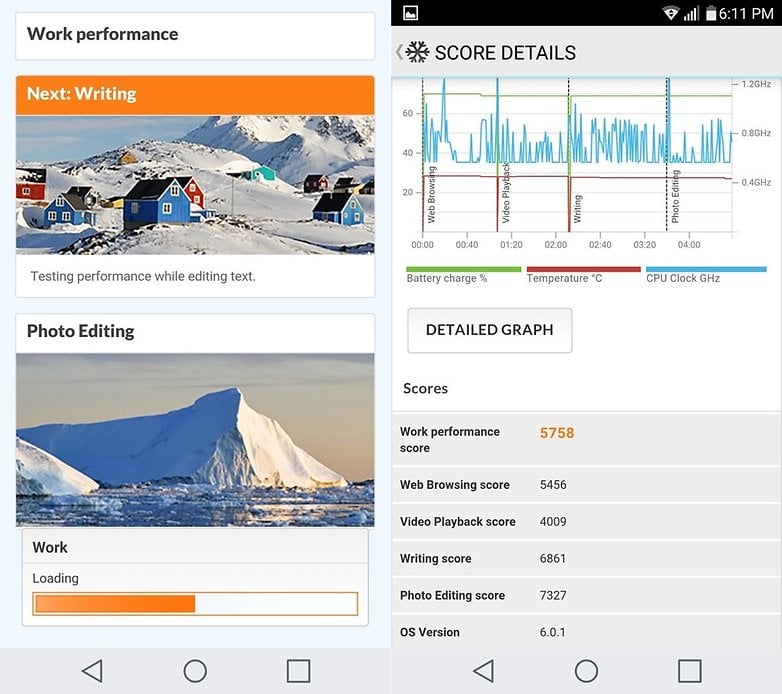

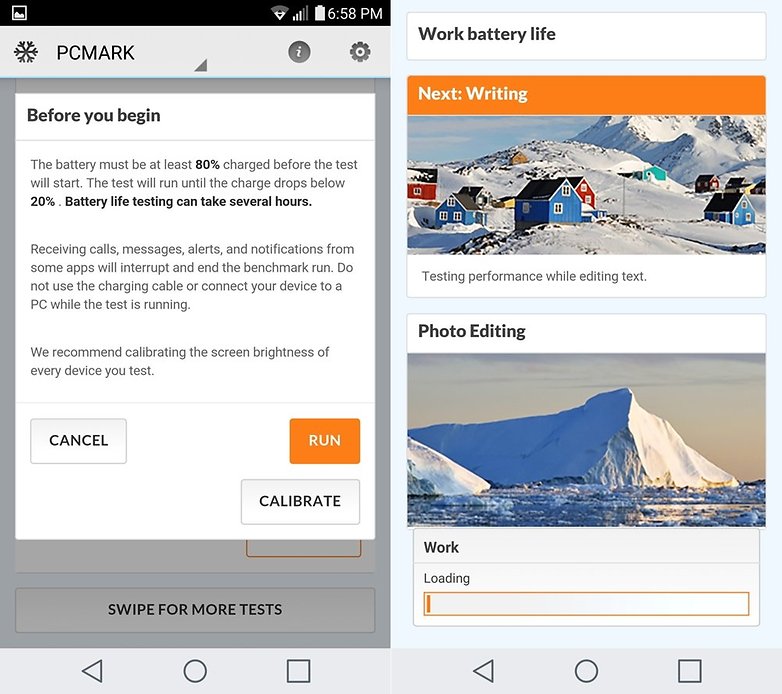

Der Benchmark PCMark for Android will ein breites Spektrum realitätsnaher Anwendungen abdecken. Er simuliert dabei Bildbearbeitung, Video-Wiedergabe, Internet-Browsing und Textbearbeitung. Jede Kategorie wird einzeln mit Punkten bewertet und es wird ein vergleichbarer Gesamt-Score ausgerechnet, den Ihr in der Online-Datenbank mit anderen Geräten abgleicht.

PC Mark beinhaltet auch einen Akku-Test. Für diesen lässt die App den Work-Test in Schleife laufen, bis der Akkustand von 80 auf 20 Prozent fällt. Das Ergebnis wird in Stunden und Minuten ausgegeben. Leider müsst Ihr Euch dann selbst darum kümmern, dass das Display auf eine normierte Helligkeit geregelt ist. Eingehende Anrufe können den Test abbrechen, Hintergrund-Apps, Temperatur, Alter des Gerätes oder Signale von WLAN beziehungsweise LTE können das Ergebnis chaotisch beeinflussen.

Ein neuer Teiltest, den Ihr separat herunterladen könnt, ist der Speicherbenchmark. Dieser misst die Geschwindigkeit des internen Speichers. Genau hier ergeben sich oft spürbare Leistungsunterschiede zwischen zwei ansonsten ähnlich ausgestatteten Smartphones. Insbesondere das HTC 10 hat hier im Vergleich etwa zum Galaxy S7 enttäuscht, da HTC langsamen Speicher verbaut. So habt Ihr zwar in beiden Geräten eine gute Leistung in Spielen, habt vorher aber lange Ladezeiten beim HTC 10.

Was wir lernen und was fehlt

Der PC Mark für Android liefert mit seinen Komponenten nützliche Erkenntnisse, anhand denen sich Smartphones miteinander vergleichen lassen. Dank der Punkte-Ergebnisse ergibt sich eine schnelle, einfache Vergleichbarkeit, die jeder von Euch mühelos nachvollziehen kann. Das Problem: Der Benchmark ist etwas zu einfach.

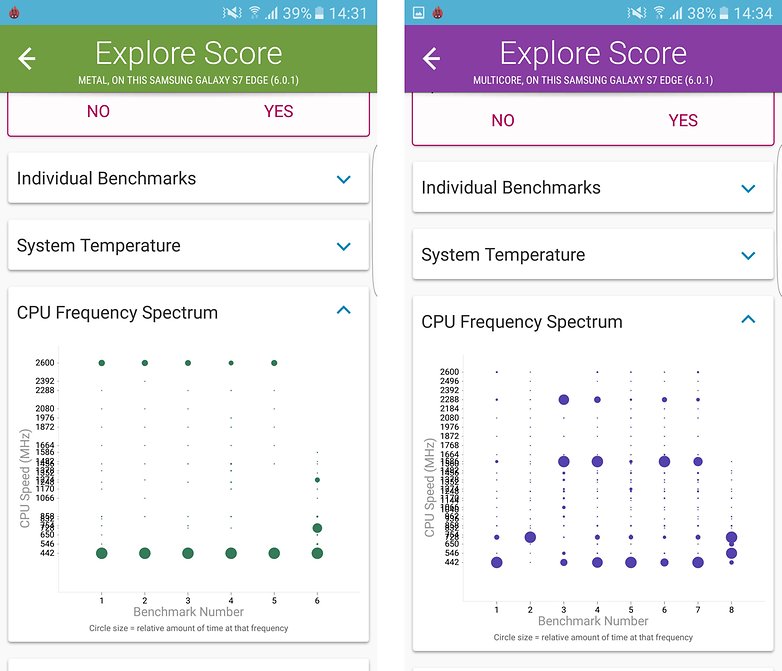

In den Benchmark-Details finden sich nicht alle Infos, die wir brauchen: Wie viele Prozessorkerne wurden genutzt? Wie schnell ist der RAM? Wie flott arbeitet der Grafikchip? Ist der Browsing-Benchmark auch abhängig von Eurer Internetgeschwindigkeit?

Viele jener Details findet man unter anderem im Vellamo-Benchmark des Prozessor-Hestellers Qualcomm. Jene App hat wiederum den Nachteil, dass ihre Tests nur mathematische Probleme lösen und alltägliche Aufgaben rein theoretisch abhandeln.

Gaming-Performance ist mehr sicht- als messbar

Spiele-Benchmarks haben eine ganz andere Sorge bereiten. Ihr Nachteil ist, dass sie nicht das widerspiegeln, was in echten Gaming-Apps und mit echten 3D-Engines geschieht. Denn Spiele wie Real Racing skalieren nicht mit der Frequenz der pro Sekunde gezeichneten Frames (fps). Sie skalieren mit dem Detailgrad des angezeigten Materials, um ein bestimmtes fps-Ziel zu erreichen.

Apps erkennen also die Spezifikationen Eures Smartphones und passen sich entsprechend an. So schaltet die Facebook-App in manchen unserer Testgeräte das 360-Grad-Feature ab. Stoßt Ihr auf ein solches Bild in Eurer Timeline, lässt es sich nicht als sphärisches Panorama betrachten.

Diese subjektiven Kleinigkeiten fallen im Alltag störend auf und werden von einer Benchmark-App nicht erfasst. Also müssen wir uns etwas Neues überlegen.

Was wir von Euch brauchen

Und jetzt kommt Ihr ins Spiel. Welche Test-Apps oder Skripte habt Ihr entdeckt? Welche liefern eine gut vergleichbare Basis für dauerhafte, groß angelegte Tests? Welche Fallstricke habt Ihr mit unterschiedlichen Smartphones im Alltag bemerkt, über die man sehr einfach stolpert? Hinterlasst gerne einen Tipp und eine genauere Erläuterung im Kommentarfeld, damit wir uns genauer mit dem Thema Benchmarks und Leistungsmessung auseinandersetzen können.

Ich finde den Artikel sehr gelungen, und das Vorhaben, aussagekräftige Testsuiten oder Benchmarks zu entwickeln, sehr zu begrüßen, aber mindestens ebenso ambitioniert. Die ganze Materie ist höchst komplex. Wertet man die Aussage des Benchmark nicht richtig, zieht man die falschen Schlüsse daraus.

Gut sehen kann man das daran, dass Geräterankings, abhängig von den gefahrenen Benchmarks, nicht immer gleich ausfallen.

Zu einem guten Benchmark gehört also eine exakte Beschreibung, aus der ersichtlich ist, worüber genau der Benchmark eigentlich eine Aussage macht, und Beispiele, für welche Anwendungsfälle das relevant ist.

Auch die Randbedingungen des Tests sind wichtig. Ob ein Benchmark auf einem zurückgesetztem Gerät durchgeführt wird, oder aber auf einem verkonfiguriertem Gerät mit 300 Apps, dürfte nicht ganz ohne Einfluss bleiben, und es sollte daher festgeschrieben werden, um Beschwerden über die Nicht-Reproduzierbarkeit des Benchmark möglichst zu vermeiden, in welcher Umgebung der Benchmark durchgeführt wurde (und über wieviele Läufe gemittelt wird usw. natürlich auch).

Selbst die Umgebungstemperatur kann einen wesentlichen Einfluss haben, da auf einem schon warmen und runtergetakteten Gerät kurze Leistungsspitzen weniger performant ausgeführt werden, als auf einem kalten Gerät das nicht herunter getaktet wird.

Vielleicht wäre eine Umfrage über die am häufigsten installierten Apps hilfreich, um daraus eine Normumgebung zu definieren, in der z.B. WhatsApp, Flickr und was weiß ich noch unter Android 6.01 installiert ist. Ja, ich würde Android 6.01 vorschlagen, auch wenn die Mehrzahl der Installationen noch unter 5.x laufen sollte. Für diese Anwender ist der Benchmark dann zwar nur eingeschränkt aussagekräftig, aber solche altbackenen Tests sind einfach nicht so interessant, und für Neuanschaffungen auch nicht mehr wichtig.

Wie schon an anderer Stelle hier geschrieben, kann unter Umständen die Verfügbarkeit einer älteren Version des selben Benchmark interessant sein, auch wenn man die bisher noch gar nicht genutzt hat. Das dürfte mit der Zurverfügungstellung nicht ganz einfach sein, eigentlich bräuchte man ein Repository dafür, aber wenn ich mich nicht irre, leistet das der Playstore nicht. Man könnte aber die APK's in verschiedenen Versionen in einem eigenen Repository zur Verfügung stellen.

Des weiteren könnte man z.B. bei 22 Grad Umgebungstemperatur auf einem seit einer Stunde eingeschaltetem, aber ruhendem Gerät testen.

Und dann stellt sich natürlich noch die Frage, welche Eigenschaften eigentlich durch Benchmarks gestestet werden sollen, welche also für den durchschnittlichen AP-Leser von besonderem Interesse sind. Sicherlich interessant wären ein paar Anwendungsbenchmarks oder Spielebenchmarks.

Sollte man darüber hinaus aus den Benchmarks Rankings erstellen, sollten diese fair gestaltet werden, und auch alle aktuellen Geräte enthalten.

So fehlt z.B. im aktuellen AnTuTu-Ranking im AP-Artikel "AnTuTu kürt die 10 schnellsten Smartphones der ersten Hälfte 2016" ( https://www.androidpit.de/antutu-kuert-die-10-schnellsten-smartphones-der-ersten-haelfte-2016 ) sowohl das HTC 10, als auch das LG G5, obwohl beide Geräte von ihrer Punktezahl darunter fallen würden, das HTC 10, obwohl es noch keinen UFS-2-Flash verbaut hat, sogar ganz vorne liegen würde.

Meine Kritik gilt hier allerdings nicht dem Autor des Artikels, der nur erfüllt, was er auch verspricht, nämlich die AnTuTu-Wertung zu erläutern, sondern eher AnTuTu selber, das im Test fürs erste Quartal diese beiden wichtigen Geräte nicht berücksichtigt, weil sie erst im April released wurden, sie in den nachfolgenden Tests aber nicht berücksichtigt, obwohl sie da released waren.

Ebenfalls bivalent kann das Ranking des S7 in diesem Vergleich gesehen werden. So schreibt AnTuTu zwar ausdrücklich, dass die 2K-Auflösung des S7 einen erhöhten Ressourcenverbrauch bewirkt, und das Ranking dadurch schlechter ausfällt, als das von Vergleichsgeräten mit kleinerer Auflösung. Die Einschränkung wird beschrieben, der Vergleich ist im Prinzip also nicht unfair.

Für jemanden, der die höhere Auflösung nutzt (in Spielen, oder Videos, oder auch nur sie generell als schöneres UI genießt), stellt sie aber einen echten Mehrwert dar, das Gerät erbringt eine Zusatzleistung, die der Test aber nicht berücksichtigt, sonst müsste er die Punktezahl entsprechend hochskalieren.

Unter einem anderen Blickwinkel, von jemanden aus gesehen, der die höhere Auflösung aber gar nicht aktiv nutzt, und nur telefoniert, etwas surft oder Allerweltsapps nutzt, ist es dagegen nicht relevant, dass es die höhere Auflösung ist, die die Performance reduziert.

Aussagekräfte Benchmarks zu erstellen, und erst recht faire Rankings darauf aufzubauen, ist also eine diffizile und höchst anspruchsvolle Aufgabe.

Gerade deshalb wünsche ich viel Glück und Erfolg dabei.

http://www.antutu.com/en/view.shtml?id=8216

http://www.mobilegeeks.de/artikel/vergleich-g5-s7edge-huawei-p9-antutu-benchmark/

http://www.giga.de/smartphones/htc-10/news/staerker-als-das-galaxy-s7-edge-htc-10-dominiert-im-antutu-benchmark/

Quellen: www.antutu.com, www.mobilegeeks.de, www.giga.de (mir genannt durch markus riedberger)

> Die Messwerte müssen langfristig vergleichbar bleiben

Das ist ein Kardinalfehler! Ihr wollt zwei Geräte vergleichen. Dann müssen sie auch unter exakt gleichen Bedingungen getestet werden und dazu gehört der gleiche Zeitpunkt. Ihr habt es ja selbst gemerkt, dass bereits ein Update die Vergleichbarkeit nicht mehr ermöglicht.

Auch die API´s ändern sich mit den verschiedenen OS Versionen und auch da gibt es dann kleine Unterschiede.

Da will ich widersprechen. Der Leistungsgewinn zwischen Geräten verschiedenen Alters ist häufig, wenn auch nicht zwingend in der Mehrzahl der Fälle, ein besonderer Mehrwert für den Leser des Tests oder Benchmarks, und für dessen Kaufentscheidung wesentlich. Und die Testaussage häufig genug eindeutig. Will ich wissen, wieviel Floating-Point-Operationen doppelter Genauigkeit pro Sekunde die CPU eines SoC bewältigen kann, so ist das eine vom Alter des Gerätes oder dessen Softwarestand unabhängige Forderung, um z.B. eine Schaltungssimulation darauf ablaufen lassen zu können. Die Forderung als solche ist auch davon unabhängig, ob die CPU-Architektur 32 Bit oder 64 Bit breit ist, oder spezielle Vektor-Rechenbeschleuniger enthält.

So kann es für einen Anwender höchst interessant sein, ob seine Simulation auf einem neuen S7 bedeutend schneller läuft, als auf seinem derzeitigen S6.

Der Benchmark, der diese Aussage für das S6 liefert, reizt aber die neue CPU des S7 unter u.U. gar nicht richtig aus, da er zwar vorwärtskompatibel ist, also prinzipiell läuft, aber z.B. neue Recheneinheiten nicht nutzt, da er dafür neu übersetzt werden müsste.

Es ist jetzt eine Forderung an den Benchmark und eine Aussage über seine Qualität, ob er, neu übersetzt, eine Aussage liefert, die dem Anwender den Vergleich mit der alten Architektur erlaubt. Der Anwender will wissen, wieviel Floating-Point-Operationen doppelter Genauigkeit das neue Smartphone im Vergleich zum alten Gerät schafft, ob eine Neuanschaffung in Hinblick auf seine spezielle Anwendung sich also lohnen dürfte. Es ist Aufgabe des Benchmarks diese Aussage zu liefern, und im vorliegenden Fall eine einfache Messaufgabe, angewandt auf einen definierten Satz von Testfällen, aber prinzipiell unabhängig vom Zeitpunkt der Ausführung und dem Gerät.

Eine Einschränkung will ich aber gleich nachschieben, um auch zu verdeutlichen, dass die ganze Thematik höchst komplex ist:

Will der Simulationsanwender zwar eine Steigerung seiner Simulationsleistung, sich aber keine Upgrade dafür gönnen (was bei solchen Programmen häufig (sehr) kostenpflichtig ist), ist der alte Benchmark für ihn dennoch aussagekräftiger, denn die alte Simulation ist ja ebenfalls nur für die alte CPU übersetzt, und reizt die neue nicht aus. Die höhere Floating-Point-Leistung könnte die neue CPU zwar liefern, die alte Anwendung ruft sie u.U. aber gar nicht ab.

Erst wenn er auch die Simulation selber bereit ist upzudaten, liefert der neu übersetzte Benchmark eine grobe Abschätzung, darüber, mit welcher Steigerung er bei der Simulationsrechnung rechnen darf.

Ich lese seit vielen Jahren die c't und verfolge mit besonderem Interesse Hardwaretests, die dort auch mit selbstdefinierten Testsuiten durchgeführt werden. Eine der Bestrebungen ist es eben, möglichst Vergleichbarkeit der Tests mit denen aus älteren Zeitschriften zu gewährleisten, weil darin ein Mehrwert für den Leser besteht.

Allerdings weist man dort ab und zu auch darauf hin, dass ein neuer Test grundlegend anders ausgelegt wurde, und die Vergleichbarkeit mit älteren Tests dadurch nicht mehr gegeben ist. Da darauf hin gewiesen wird, kann man damit leben, und der Umstand ist eben der rasch fortschreitenden Entwicklung geschuldet.

Und da liegt der Hase im Pfeffer! Eine App, die auf dem Betriebssystem aufsetzt, hat viel zu viele Elemente dazwischen, als dass man einen Wert der CPU halbwegs korrekt ermitteln könnte. Will ich CPUs vergleichen, messe ich diese im gleichen Messumfeld außerhalb der Geräte, in denen sie verwendet werden.

Ein Benchmark wie AnTuTu und Konsorten als App ist Pseudomessung! Diese auch noch archivieren zu wollen um generationsübergreifend vergleichen zu können, bereits im Ansatz zum Scheitern verurteilt.

Die ganzen Benchmark-Apps sind Spielzeug, um sich selbst zu beweisen, dass das eigene Smartphone doch um 150 Punkte besser ist als das der Freunde.

Teilweise gebe ich Dir recht. Wollte ich nur die CPU, oder sogar die CPU und die umgebende Hardware innerhalb und ausserhalb des SoC testen, so müsste man ein spezielles Testprogramm dazu flashen, das die Messung ausführt, aber selber möglichst wenig beeinflusst (ein klassisches Messproblem, ein Strommesser z.B. reduziert selber den zu messenden Strom, verfälscht also alleine durch die Durchführung der Messung ihr Ergebnis).

Will ich aber eine Aussage darüber, wie sich eine bestimmte Hardwareumgebung in Verbindung mit einem bestimmten Betriebssystem verhält, was für die praktische Anwendung viel wesentlicher ist, als der reine Vergleich der CPU-Geschwindigkeiten, so ist es natürlich sinnvoll, die Messung unter Einbeziehung des Betriebssystems durchzuführen.

Auch andere Tester wie besagte c't nutzten solche Benchmarks. Sie sind vielleicht nur von eingeschränkter Genauigkeit, aber dafür einfach durchzuführen. Schon die beschriebene Messung mit dem Spezialprogramm ist ein viel größerer Aufwand als eine Benchmark-App zu installieren. Und es ist eben auch schon fast eine Art Prinzip: Je genauer ich messen will, umso aufwändiger und teurer wird die Messung.

Und wie schon in anderen Kommentaren geschrieben:

Oft ist es ja völlig Banane, ob ein Gerät 3 Prozent schneller oder langsamer ist als ein anderes.

Der Aufwand für eine Messung sollte sich also an der Bedeutung ihrer Aussagekraft messen.

Will ich nur eine grobe Einordnung eines Gerätes in eine Leistungsklasse, um abzuschätzen ob es meine Erwartungen erfüllen wird (die ja auch nicht absolut exakt, sondern nur unscharf festgelegt sind) sind Benchmarks ein hinreichend genaues, aber nicht zu teures Messmittel, deshalb würde ich sie nicht als Spielzeug einstufen.

Ihre Aussagekraft steht und fällt aber mit der richtigen Interpretation der Messung, die nicht immer ganz einfach ist. Eine hohe GPU-Geschwindigkeit garantiert eben noch kein schnelles Laden von Apps.

Wer nicht sehr spezielle Messaussagen in einem bestimmten Anwendungskontext interpretieren will, fährt vielleicht mit Anwendungsbenchmarks besser, die konkrete Zeitmessnungen z.B. bis zur Nutzbarkeit einer Officeanwendung, einer Browseranwendung usw. durchführen, und die besser vorstellbar sind.

Anderseits, wie will man überhaupt Aussagen über Gerätegeschwindigkeiten ohne solche Benchmarks machen? Das subjektive Empfinden verschiedener Anwender kann's ja auch nicht sein, genausowenig wie das Bemühen der guten alten Stoppuhr.

Und wie in dem Beispiel mit der Simulation beschrieben:

Manchmal interessieren nur nackte Werte, ob mit altem OS oder neuem, upgegradeter App oder ohne. Der Anwender will Ausführungszeiten unter einer festgelegten Umgebung. Eine detaillierte Analyse einzelner Faktoren interessiert ihn nicht. Liefert eine andere Umgebung bessere Ergebnisse, entscheidet er sich eben für diese.

Damit sind wir aber wieder bei meiner ursprünglichen Aussage: Eine Archivierung von Messwerten und ein Vergleich von Messwerten zu unterschiedlichen Zeitpunkten ist Unsinn, wenn ich zwei Geräte vergleichen will.

Archivierte Messwerte machen Sinn, wenn ich die Veränderung ein und des selben Geräten über die Zeit dokumentieren möchte.

Hinzu kommt, dass Du Recht hast, dass die Differenzen oft völlig Banane sind. Aber Benchmarks sind offenbar für den interessierten Laien das Maß der Dinge.

Ich sehe da keine Kreisargumentation. Aber egal ob Du nun meinen Argumenten folgen willst oder nicht, man setzt dennoch Benchmarkvergleiche über längere Zeiträume ein, wie die unten verlinkte Seite zeigt. Ich sehe da auch nach wie vor keine grundsätzlichen Hindernisse, insbesondere wenn die Benchmarks konkrete Ergebnisse wie Anzahl der Floating-Point-Operationen pro Sekunde oder Speichertransfers pro Sekunde liefern. Liefern sie nur reine Zahlen, die irgendwie errechnet werden, vor allem bei Anwendungsbenchmarks, ist es vielleicht schwieriger, diese Vergleichbarkeit über die Zeit sicherzustellen, sollte bei sorgfältiger Auslegung aber dennoch möglich sein. Da sich aber auch die Komplexität der Anwendungen selber im Lauf der Zeit ändert, die Geschwindigkeit der Internetzugänge usw., sind solche Vergleiche über längere Zeiträume vielleicht auch weniger sinnvoll. Für kürzere oder mittlere Zeiträume im Bereich von zwei bis fünf Jahren sollten sie aber noch sinnvoll möglich sein.

Benchmarks werden auch von Profis, z.B. beim Vergleich unterschiedlicher Server eingesetzt, als Entscheidungsgrundlage für Neuanschaffungen, aber auch zur Dokumentation von erreichten Leistungssteigerungen über die Zeit, so wie bei den Smartphonelisten unten auch. Bei Prozessoren sowieso, aber auch bei Finanzprodukten und in weiteren Bereichen.

Allerdings kann man hoch komplexe Produkte nicht simplen Vergleichen unterziehen. Entweder man reduziert die Vergleiche bewusst auf einzelne Aspekte, wie z.B. die Floatingpoint-Geschwindigkeit, oder man definiert komplexe Testsuiten, deren Ergebnisse man aber nicht einfach hinnehmen darf. Vielmehr ist deren Relevanz für die eigenen Ziele zu untersuchen, und ggf. eine anders zusammengesetzte einzusetzen.

Schon eine ganz einfache Zusammenfassung zweier solcher Messungen verdeutlicht das:

Fasst ein einfacher Benchmark z.B. Integer- und Floating-Point-Leistung zusammen, bewertet die Floating-Point-Leistung aber nur mit 20 % und die Integer-Leistung mit 80 %, so kann ein Gerät das eine überragende Benchmarkleistung darin erzielt, dennoch genau falsch sein, wenn es im Floating-Point-Bereich nur schlecht performt, die Leistung darin für die ins Auge gefasste Anwendung aber gerade wichtig wäre.

http://www.androidbenchmark.net/device_list.php

Weiter so, jetzt macht es endlich wieder Spass hier Artikel zu lesen.